Ricardo C. Rezzónico

Director GINGEOS (Grupo de Investigación e Innovación en Gestión Estratégica Organizacional Sustentable), Universidad TecnológicaNacional, Facultad Córdoba. Maestro López y Cruz Roja Argentina, Ciudad Universitaria. Córdoba, Argentina. Cel:+(54 9 351) 6069124. rrezzonico@posgrado.frc.utn.edu.ar

Maria Nelay Colussi Artusso

Becaria GINGEOS (Grupo de Investigación e Innovación en Gestión Estratégica Organizacional Sustentable), Universidad Tecnológica Nacional, Facultad Córdoba. Maestro López y Cruz Roja Argentina,Córdoba, Argentina. nelay_colussi@yahoo.com.ar

Gladys Muñoz

Becaria GINGEOS (Grupo de Investigación e Innovación en Gestión Estratégica Organizacional Sustentable), Universidad Tecnológica Nacional, Facultad Córdoba. Maestro López y Cruz Roja Argentina, Córdoba, Argentina. gladysutn@hotmail.com

RESUMEN

Considerando a la prevención como una estrategia poderosa para la gestión de SySO, se abordan los conceptos cultura organizacional y cultura de la seguridad, a fin de establecer los vínculos entre sí y con las lógicas de gestión del riesgo. Se analiza la influencia del error humano en los incidentes y accidentes y se detallan los componentes básicos de la prevención, avanzando en el análisis de los modos en que la percepción de los riesgos influye –junto a la información sobre su evaluación y la incertidumbre- en la toma de decisiones respecto a las políticas de prevención. Finalmente, se analizan factores que inciden en los costos y las inversiones de seguridad, brindando elementos para re-valorizar los aspectos de responsabilidad interna / externa, mencionando estrategias de identificación de procesos y actividades críticas para la sistematización del control de riesgos, como claves para lograr organizaciones seguras, saludables y responsables.

Palabras claves

Culturas, prevención, gestión, riesgo, seguridad laboral.

INTRODUCCIÓN

La seguridad y la salud ocupacional se han ido constituyendo en una preocupación incremental y constante para un porcentaje importante de empresas y organizaciones de todo tipo en nuestras sociedades. En tal sentido, diversas acciones y numerosos programas, de alcances tanto local, nacional como internacional, se han desarrollado a lo largo de los años para intentar reducir el número de accidentes -originados por los más diversos factores- y el sufrimiento humano asociado con ellos, considerando también otras cuestiones preocupantes(que determinadas lógicas economicistas colocan en el centro del análisis) como son los daños materiales, los costos en la forma de licencias por enfermedad, la reducción de los ingresos de las familias y las erogaciones por atención médica emergente de tales eventos e infortunios (Ioannis et al., 2007).

Todos estos aspectos confluyen en el impulso permanente a la prevención y la gestión de los sistemas socio-técnicos bajo la lógica de una reducción de los riesgos laborales presentes en ellos, aunque un reto central estratégico para aumentar su efectividad consistiría en avanzar en la identificación del conjunto de aspectos clave que deben abordarse para la optimización de tales estrategias de intervención preventivo-correctivas.

Las cuestiones relativas a la interpretación acabada de las causas de los errores humanos, la exploración activa y rigurosa del conocimiento sobre los componentes de la seguridad, las percepciones del riesgo que poseen los actores organizacionales, la toma incremental de conciencia sobre la prevención y el desarrollo del compromiso en su gestión cotidiana, aspectos –todos ellos- que integran y desarrollan una cultura de la seguridad sólida, merecen especial atención y, como lo plantean Mengolini y Debarberis (2006), abordar su estudio y comprensión holística puede constituirse de importancia fundamental para el desarrollo de estrategias efectivas de prevención en las organizaciones.

DESARROLLO

Cultura organizacional y cultura de seguridad en la organización

Al analizar aspectos claves sobre la prevención y como un punto de partida útil para la discusión, Ostram et al. (1993) tienen en cuenta la Teoría de Dominó de Heinrich

-desarrollada en la década de 1930 y de tono más especulativo que experimental-que se basa en la premisa de que un entorno social propicio a los accidentes era el primero en caer –de un dominó de cinco fichas- en la secuencia de ocurrencia de un accidente.

Heinrich –para quién el 88 % de los accidentes están provocados por actos humanos peligrosos, el 10%, por condiciones peligrosas y el 2 % por hechos fortuitos, aunque no aportara datos experimentales al respecto- propuso tal secuencia de cinco factores -en la que cada uno actuaría sobre el siguiente de manera similar a como lo hacen las fichas de dominó, cayendo una sobre otras- explicitándolos así: 1) antecedentes y entorno social; 2) fallo del trabajador; 3) acto inseguro unido a un riesgo mecánico y físico; 4) accidente; y 5) daño o lesión. Propuso además que, la eliminación de uno de los factores evitaría el accidente y el daño resultante, siendo la ficha cuya retirada es esencial la número tres.

El concepto entorno social utilizado allí hace referencia, en definitiva, a una determinada cultura organizacional o de una sociedad en particular, en un momento dado. En tal sentido, Uttal (1983), en sus investigaciones sobre los fundamentos humanos en las empresas, resume el significado de la cultura organizacional como un sistema que comparte los valores (lo que es importante) y creencias de las personas (el modo en cómo funcionan las cosas) que interactúan en una estructura organizativa y los sistemas de control para producir normas de comportamiento (la manera en que se hacen las cosas).

Por su parte, Bridges (1992) advierte y señala que hay diferencias importantes entre el concepto cultura, comúnmente usado por los antropólogos y la cultura como es percibida por los consultores en gestión de organizaciones, pues éstos simplifican algunas cuestiones hasta tal punto, que el concepto pierde gran parte de su conexión con los usos actuales del campo al que pertenece. Apostolakis y Wu(1995) se preguntaron si el término cultura de la seguridad es adecuado y sugieren que el mismo es definido habitualmente de un modo estrecho. Indican que debemos ser lúcidos y poseer la sabiduría de separar la cultura de la seguridad de la cultura que existe -por ejemplo- con respecto a la operación normal de una planta o institución; aunque éstas, en muchos casos, se presentan con similitudes, como Reason (1997) hace notar al demostrar que -dentro de una cultura organizacional- ciertos asuntos poseen las mismas lógicas, como por ejemplo las cuestiones de calidad en la producción y los asuntos de protección/prevención, que dependerían de un mismo proceso organizacional. No obstante, a pesar de las reservas de algunos investigadores, el concepto de cultura de la seguridad parece ser aceptado como apropiado y útil, no obstante que su relación con la cultura organizacional, en el sentido habitual, es tenue. Atribuir el significado usual y característico de cultura a la cultura de seguridad debe hacerse con cierta cautela; este último, poseería los límites propios de una de las muchas subculturas que pueden percibirse dentro de la organización. Así, la definición adoptada para designar cultura de la seguridad, debería ser consistente con sus términos madres tradicionales: cultura y cultura organizacional. Un objetivo práctico podría ser establecer un vínculo entre la cultura de la seguridad y la seguridad de las operaciones; este proceso requiere no sólo de una definición, sino también de una delimitación de las características o atributos de la cultura de seguridad. Tales atributos deben ser coherentes con la definición elegida, pero probablemente - según Sorensen (2001)- sean más importantes que la definición misma.

La cultura de la seguridad, debido a su naturaleza interdisciplinaria, tiende a ser un concepto de interés para los académicos de diferentes áreas del conocimiento: desde las ciencias sociales -como la sociología, la psicología y la antropología- a las disciplinas más técnicas, como el mantenimiento, la ingeniería de confiabilidad y de los sistemas de seguridad; por tanto, el consenso sobre el significado del término se hace un tanto difícil y comprensibles los múltiples abordajes. En la perspectiva de Schein (1992), la cultura se presenta como un patrón a compartir, con supuestos que son desarrollados a través de un proceso de adaptación externa y de integración interna que opera en los miembros de una organización. En tal sentido, la cultura es un mecanismo de integración social que proporciona la unión entre los miembros (Richter y Koch, 2004) y se caracteriza por la coherencia, la organización, un amplio consenso y la claridad (Martin, 2004). Sin embargo, debe reconocerse que existen otras perspectivas, como la de diferenciación y la de fragmentación. La perspectiva de diferenciación describe las organizaciones como un compuesto de superposición de culturas que coexisten en relación a la armonía del grupo, el conflicto o la indiferencia, mientras que la perspectiva de la fragmentación sostiene que la ambigüedad es una de las características de las culturas en las organizaciones (Martin, 2004). De hecho, parece ser controvertida la manera de conceptualizar y de analizar el desarrollo de las culturas organizativas y la teoría de la cultura de la seguridad (Hale, 2004); sin embargo, está fuera del ámbito de abordaje del presente documento argumentar de modo extenso acerca de las diferentes perspectivas y definiciones sobre un tema tan debatido.

A los efectos de avanzar en la presentación de conceptos importantes en uso sobre éstas cuestiones, se considera apropiado realizar una distinción entre la cultura de la seguridad y el clima de seguridad, pues la primera pareciera estar ganando terreno a expensas de la segunda. Según esta distinción, la cultura de seguridad es reservada a los supuestos básicos de la organización que son estables y profundos, mientras que el clima de seguridad se utiliza para estados de la organización que son poco profundos, más coyunturales y volátiles. Estas cuestiones podrían explicar la tendencia a una valoración mayor y el abordaje más detallado de los aspectos de una cultura preventiva en lo relativo a riesgos.

Si se considera un plan de instalación o mejora de la cultura de la seguridad en una organización, se pueden distinguir –siguiendo a Vautier et al. (2003)- dos enfoques principales, el macroscópico y el microscópico. El enfoque macroscópico, dondepueden identificarse acciones tales como la mejora de los procedimientos y especificaciones técnicas, la mejora del plan de formación y la evaluación comparativa con otras organizaciones similares o del mismo rubro, en donde el objetivo ulterior de estas acciones es mejorar las condiciones de la gestión del trabajo y en los procesos. Por su parte, en el enfoque microscópico, se consideran acciones tales como la constitución de los comités de seguridad, la gestión participativa de los equipos de proyectos y mejoras, la ejecución sistemática de entrevistas y encuestas, la aplicación de técnicas de sensibilidad al rumor, etc.; acciones que tienen por objeto identificar las preocupaciones del personal para la posterior mejora de las condiciones de trabajo.

Como lo plantea el International Nuclear Safety Advisory Group (INSAG-4, 1991), desde el nacimiento de la cultura de la seguridad, se relaciona el concepto con actitudes personales, hábitos de pensamiento y el estilo de gestión presente en las organizaciones; sus estudios sugieren que asuntos que son en general inmateriales, conducen a manifestaciones materiales (por ejemplo, la tensión psicológica – inmaterial- lleva a un accidente por caída de nivel –manifestación material-), y que el requisito principal para el impulso a una cultura de seguridad sería el desarrollo de los medios de las manifestaciones tangibles, utilizadas para probar lo que está subyacente. Así, los procedimientos y buenas prácticas no son suficientes si se limitan a ser efectuados mecánicamente. INSAG-4 sostiene también que la cultura de seguridad exige que todas las funciones importantes para la prevención de riesgos se lleven a cabo correctamente, con un estado de alerta en el pensamiento y el completo conocimiento, buen juicio y sentido propio de la capacidad y habilidades de que se dispone.

En dicho ámbito y en los últimos años –como indicador de la importancia y el interés creciente por un desarrollo del concepto- algunos organismos como el IAEA (International Atomic Energy Agency) han desarrollado programas y directrices encaminadas a mejorar la cultura de la seguridad. Estas directrices (IAEA, 2002a, 2002b) se centran principalmente en cubrir adecuada y sistemáticamente la mayoría de los pasos comunes necesarios para cualquier tipo de instalación, tales como las encuestas, la autoevaluación, los planes de mejora, la evaluación comparativa, etc.. Tales acciones son un emergente del desarrollo de programas enfocados a mejorar y mantener a salvo a las personas de los accidentes, no sólo como obligación de prevenir consecuencias adversas para los seres humanos y el medio ambiente, sino también para evitar daños tecnológicos y económico-sociales importantes.

En tal sentido, la capacitación, la formación y el entrenamiento -la educación, en general- deben garantizar el conocimiento del personal acerca de los posibles peligros, errores y riesgos en el área de actividad de cada individuo (Sorensen, 2001), y las preocupaciones de seguridad deben dar un alto nivel de visibilidad a las no conformidades –críticas o leves- y oportunidades de mejoras detectadas por las inspecciones, las auditorías, las reuniones de análisis y en los seminarios de seguridad. Se debería proporcionar al personal instalaciones satisfactorias, incluyendo herramientas, equipos e información pertinente (conteniendo prácticas seguras detalladas en todos los niveles dentro de las rutinas diarias de trabajo, a través de especificaciones, procedimientos y registros adecuados), en virtud de lo sugerido por Deal y Kennedy (1982), quienes indican claramente que una cultura indocumentada posee una influencia negativa para la gestión de los riesgos. Ambos, en sus publicaciones, también advirtieron sobre las limitaciones de la estructura de una organización, que a menudo no explica adecuadamente el control que se ejerce en las actividades de trabajo.

Según Sorensen (2001), otros elementos claves de la cultura de la seguridad deben encontrarse en la ejecución de revisiones regulares del desempeño de seguridad de la organización y en la evaluación de las actitudes individuales hacia la seguridad, como parte de los procesos de selección e inducción del personal y los depromoción, dentro de la carrera laboral/profesional de la organización. Una estrategia complementaria posible es la indicada por Stoop (2009), que sugiere abordar una gestión basada en el conocimiento y desarrollar el concepto de organizaciones de aprendizaje aplicados al ámbito de la seguridad laboral, así como Rezzónico (2008) lo extiende a otras dimensiones y aspectos significativos para el logro de organizaciones más seguras, saludables y responsables.

Las actitudes individuales se reflejan por la adhesión explicita y/o implícita a los procedimientos seguros, por las formas de actuar cuando se enfrentan a imprevistos y por poseer una buena predisposición hacia los asuntos de seguridad y salud laboral en la gestión cotidiana. En tal sentido, también los gerentes y/o mandos medios deben ser capaces de demostrar que pondrán los asuntos de seguridad por delante de otros aspectos menos relevantes, si las circunstancias así lo justifican.

Todas estas acciones y medidas, examinadas e insertas como elementos sistemáticos de estrategias y políticas de prevención, deberían considerarse de modo extendido y profundo a la hora de la planificación detallada y de la gestión operativa de los riesgos presentes -y de aquellos que pueden surgir- en el ámbito laboral.

El error humano y su relación con accidentes en la organización

Como quedara explicitado en la presentación sintética de los factores en la teoría de Heinrich, el segundo factor correspondía al fallo del trabajador y uno tercero al acto inseguro unido a la presencia de un riesgo, siendo ésta última la ficha del dominó cuya retirada se valora como esencial para que no ocurra el accidente; en tal sentido, ambos factores ponen a la actuación de la persona en el centro del análisis, por lo que se avanzará en dicho sentido.

El punto focal de las preocupaciones relativas a los factores humanos es el desempeño (performance) o rendimiento de los individuos. El concepto de error humano generalmente se entiende como un acto inseguro efectuado por un operador del sistema. Las consecuencias de tal acto pueden o no ser graves, dependiendo de otras circunstancias. Tales “otras circunstancias” a menudo son el producto de factores organizacionales adicionales que establecen unas condiciones importantes que determinan la respuesta del sistema.

En su taxonomía del error humano, Reason (1990) distingue entre errores activos, cuyos efectos se dejan sentir casi de inmediato, y errores latentes, cuyas potenciales consecuencias negativas pueden estar enmascaradas u ocultas en el sistema durante mucho tiempo, sin emerger o activarse e impactar negativamente en él. Los errores activos suelen ser asociados con los operadores humanos del sistema (como los pilotos de aviones, los controladores de tráfico o el personal de control de sala de una planta de energía), mientras que los errores latentes son normalmente asociados con el personal eventualmente retirado de las operaciones que se hallan en ejecución (tales como el de diseño, construcción y personal de mantenimiento).

Diseñar y construir modelos sobre el error humano se hace necesario para comprender completamente la contribución humana a la seguridad de todo sistema sociotécnico. La recolección de información en ciertos modelos del error humano y sus datos asociados son un insumo importante para el proceso de la evaluación probabilística del riesgo. La probabilidad de un operador de cometer un error y causar un fallo en el sistema -por no llevar a cabo sus funciones- es tan importante como el fallo de un componente técnico del mismo, que conduce a idéntico o similar resultado. Modelar actos inseguros, sin embargo, es sólo una parte del proceso. Las consecuencias de esos actos -a menudo- dependen de los errores latentes. Parecerazonable esperar –entonces- que la cultura de la seguridad, y probablemente de otros factores de organización, tenga una influencia apreciable y significativa tanto en la frecuencia de los actos inseguros como en la probabilidad de errores latentes (Sorensen, 2001).

Según Dekker (2006), el error humano no debe ser considerado como la causa de un accidente, sino como un síntoma de problemas más profundos en la organización. En Human Error, Reason (1990) sostiene que la mayoría de las causas-raíz de los accidentes graves están presentes en el sistema desde mucho antes de que una secuencia de accidentes obvia pueda ser identificada. Afirma que “…algunos de estos fallos latentes podrían haber sido detectados y corregidos por los gestores que mantienen y operan el sistema en cuestión…”. En otra obra, Reason (1997), analiza las funciones de la organización implicadas en la creación o en la mitigación de accidentes y argumenta que “…el error humano es una consecuencia y no una causa. Errores (…) son constituidos y provocados en el lugar de trabajo por factores de organización…”; en consecuencia, llama a los accidentes resultantes de tales factores como accidentes de organización. Así, la comprensión acabada –y lo más completa posible- de los aspectos claves de gestión y de los factores organizacionales adicionales que pueden reducir o identificar y corregir errores latentes, son elementos fundamentales en la reducción de la frecuencia y consecuencias de los accidentes.

Según Reason (1997), normalmente los accidentes atribuibles a aspectos de organización implican “…la interacción de las condiciones latentes con eventos locales de activación…”. Describe los accidentes organizacionales en términos de: a) factores organizacionales (factores inseguros); b) factores propios del lugar de trabajo (condiciones inseguras); y c) actos inseguros. Los factores de organización y los factores propios del lugar de trabajo, no sólo interactúan directamente, sino que cada uno puede crear nuevas y propias condiciones. Los accidentes con pérdidas significantes ocurren cuando todas estas condiciones se alinean de tal manera que las defensas construidas en un sistema están desbordadas. Reason sostiene que las condiciones latentes pueden ser suficientes para causar accidentes, y que siempre están presentes en todo sistema.

Otros autores sostienen que los accidentes de trabajo a menudo tienden a ser una combinación de la actividad humana con la tecnología (Basnyat et al., 2006). Otras investigaciones llegan a la conclusión que en muchos casos los errores humanos o fallos técnicos frecuentemente son causados por defectos en el diseño inicial del sistema (Nardi, 1996) o que tienen raíces socio-técnicas (Pidgeon, 1997) y, a menudo, son atribuidos a políticas o incluso a complicaciones de la reglamentación que los diseñadores difícilmente podrían haber previsto antes de un accidente. Según Leveson et al. (1991), las técnicas de análisis de accidentes son capaces -en gran medida- de identificar la causalidad y la relación entre las causas (así como también la causalidad recíproca: causa-efecto-causa) de los accidentes.

La US Nuclear Regulatory Commission (US-NRC, 2000), ha desarrollado un método o técnica de análisis de sucesos y fiabilidad humana llamado ATHEANA (A Technique for Human Event Analysis). Para tal enfoque, los temas abordados en el análisis del concepto de la cultura de la seguridad, en general, y los errores latentes, en particular, proporcionan lo que llama el “contexto de error forzado”. El modelo proporciona un proceso de búsqueda estructurada de eventos de error humano, incluyendo procesos de búsqueda detallada de contextos de error forzado, y una mejora de representación de las interacciones sistema-seres humanos (o sistema sociotécnico).

El proceso de ATHEANA aporta al objetivo de la identificación sistemática de acciones de gestión importantes y al conjunto de los factores organizacionales que contribuyen a secuencias de eventos significativos, desde el punto de vista de la ocurrencia de accidentes; así, se ha identificado un número de factores deorganización y gestión que favorecen la aparición del evento: actividades de trabajo incompatibles, horarios de interrupción de tareas comprimidos, modelos pobres de los sistemas, la fuerte dependencia de las personas que controlan para identificar los problemas y la insuficiencia de reseñas de los procedimientos utilizados (Kaufman e Israel, 1995).

Cierta influencia de los errores latentes fue identificada en un estudio de Idaho National Engineering and Environmental Laboratory (INEEL, 2000), en el cual uno de sus objetivos era identificar la influencia de la actuación humana en eventos significantes del funcionamiento de un sistema. El estudio de INEEL encontró que la mayoría de los errores identificados estaban latentes, con ningún impacto visible inmediato. La proporción de errores latentes activos era de 4:1. Los errores latentes registrados incluyeron deficiencias de diseño, incapacidad de corregir los problemas conocidos, diseño incompleto de las pruebas, mantenimiento inadecuado de las prácticas y de los test de mantenimiento, y el mal trabajo del aseguramiento de la calidad. La información que presenta INEEL no parece distinguir entre el error latente en sí -tal como un diseño ineficiente- ni la causa del error latente, como una revisión inadecuada o incompleta del diseño o de las pruebas del cambio de diseño. Otros errores activos incluyen fallos en el mando y control, y en las acciones incorrectas de un operador (por ejemplo, actuar sin procedimiento de orientación para el trabajo).

En una evaluación estructurada del funcionamiento humano de una empresa, Shiel (2000) identificó la necesidad de focalizarse en la reducción de los errores humanos en los programas de formación de los técnicos y supervisores. Un elemento en el programa de la compañia, por ejemplo, podría ser ”compromiso individual”, que incluye un análisis de actitudes, la utilización de procedimientos de adhesión, el uso de comunicaciones, detenerse cuando no se esté seguro o bajo incertidumbre riesgosa y un enfoque prudente en general. Los mismos paralelos existen para el compromiso que los gerentes y los supervisores deben poseer de parte de otros modelos (INSAG, por caso). Como lo indica Sorensen (2001), ambos tratan con prioridades claras, objetivos explícitos, líneas claras de responsabilidad y autoridad, habilidades y competencia del personal y la permanente evaluación del desempeño.

Componentes básicos en la prevención de accidentes

Es poco probable que sólo un error -de un único operador- o un mal funcionamiento de un sólo componente –o un conjunto de ellos- se traduzca en un incidente o en un accidente de consecuencias importantes o irreparables. Normalmente, este tipo de incidentes suponen un caso inicial, con uno o más fallos de los equipos, junto con un error del operador. Cuando las causas de los eventos iniciales y los fallos de los equipos se identifican, con mayor frecuencia los errores humanos son, en parte

-si no exclusivamente- responsables. Un accidente de envergadura involucra complejas causas de organización y gestión, que pueden incluir causas en elhardware, aspectos de diseño, detalles de operación, basado en la gestión delmantenimiento, errores incluidos en manuales, la inobservación de condiciones de error, las metas incompatibles que se han fijado, mala comunicación, las cuestionesde organización y capacitación, entre otras (Geen, 2003). Dentro de los detalles delos factores de organización, los defectos ocultos de la organización deben ser investigados por medio de una evaluación técnico-psicológica de los factoreshumanos.

Lee (1998) realizó una lista de características observadas en las plantas industriales e instalaciones empresarias con bajas tasas de accidentes, a partir de una revisión de una investigación empírica sobre los aspectos de organización de la seguridad. Su lista incluía: a) un alto nivel de comunicación; b) el buen aprendizaje organizacional; c) un fuerte enfoque en la seguridad; d) el firme compromiso con laseguridad del personal directivo superior; e) un estilo de liderazgo de gestión democrática, cooperativa, participativa y humana; f) una formación e instrucción de calidad; g) buenas condiciones de trabajo; h) alta satisfacción laboral; e i) una tendencia en el personal hacia mantener hábitos de trabajo seguro. Los resultados de Lee mostraron una fuerte correlación entre la actitud positiva hacia la seguridad por parte del personal y bajas tasas de accidentes. Observó también cuestiones importantes como que “Las regulaciones han proliferado hasta el punto donde se convierten en incomprensibles y… (que) los recursos se desvían para evitar el accidente que ha ocurrido más que para evitar el más probable que ocurra…”.

La mayoría de los investigadores parecen estar de acuerdo en que las características comunes de bajas tasas de accidentes son una buena comunicación, aprendizaje organizacional intensivo, el compromiso de la alta dirección con la seguridad y un entorno de trabajo que premia identificar los errores y problemas de seguridad. Algunos investigadores también incluyen la gestión y los factores de organización, tales como un estilo participativo implícito en el modelo de gestión en uso y las habilidades -en ese sentido- del líder de gestión (Sorensen, 2001).

Un análisis de casos de éxito en la operación y mantenimiento de sistemas de prevención de riesgos laborales muestra que una serie de componentes básicos (abordados como sistemas, aunque a veces integrados en tan sólo uno o dos sistemas), son necesarios para la prevención de accidentes en organizaciones en donde la seguridad está garantizada por la integración de un motor de seguridad con la gestión de varios programas, dentro de una cultura de seguridad consolidada. Básicamente, según Geen (2003), los siguientes elementos son necesarios para su aplicación:

- 1. Un motor de seguridad (un poder activo en el sentido de su omnipresencia) que lleve a las organizaciones a mejorar la seguridad y su disponibilidad continua hacia la optimización de la prevención, el trabajo seguro y asumir las responsabilidades emergentes de ello. Este sistema debe ser una fuerza impulsora de la garantía de la seguridad, con la participación de todos los involucrados (stakeholders) en y con la organización, y puede ser implementado utilizando la metodología del TQM (Total Quality Management, o administración de la calidad total / ACT), que recomienda la activación y la continuación del ciclo plando checkact (PDCA, o PHVA, por planearhacerverificaractuar). El enfoque de modelo de gestión TQM / ACT ha demostrado que puede ser eficaz en muchos sectores industriales, comerciales y de la gestión pública. Sin embargo, si bien desde el ciclo PDCA original se propone aplicar la estadística al control de las líneas de producción en masa para reducir el número de defectos, la metodología es directamente aplicable a la reducción de los incidentes y accidentes, sin bien debe contemplarse las limitaciones estadísticas que trabajan sobre factores promedios, siendo en el caso del trabajo seguro también importantes cada uno de los eventos.

- 2. Disponibilidad de un programa específico de gestión de riesgos. Este componente puede ser combinado con otros programas o sistemas de gestión (calidad, ambiente, responsabilidad social, etc.) para constituirse en una lógica integral de actuación según ciertos valores y visiones que la organización posea y/o intente o aspire desarrollar.

- 3. Programa de evaluación del rendimiento. Saji (1991) propone la necesidad de contar con una escala objetiva para la seguridad total, que es proporcionar medidas de desempeño (indicadores, ítems de control, métricas) para la mejora continua del funcionamiento planificado del sistema. Se debe mejorar la calidad y seguridad en las operaciones y para ello es conveniente establecer objetivos medibles y de relevancia para una gestión integral de riesgos adecuada. Esto debería ser más que una simple interpretación de un sistema de evaluación, ya que una medición objetiva de la operación segura es necesaria para alimentar de datos a la gestión de otros programas (por caso: calidad, ambiente, responsabilidad).

- 4. Programa de gestión del error organizacional. Hay varias metodologías que se ocupan de cuestiones de organización antes de la ocurrencia real de un accidente. Según Rearson (1997), la motivación de las personas es esencial, ya que las cuestiones de organización están de acuerdo con el rendimiento humano. El sistema debe ser dirigido a mejorar el rendimiento humano más allá de sus habilidades de base, de estar cimentado en normas y, finalmente, fundado en el conocimiento (Rasmussen, 1982). Por su parte, Weil y Apostolakis (1999) sugieren que debe existir una metodología de investigación sistemática de incidentes, con el objetivo de identificar las deficiencias de gestión y organización que han contribuido –o pudieran contribuir a la ocurrencia de accidentes.

- 5. Ingeniería de la cultura de la seguridad. Se tiene que establecer una buena cultura de seguridad (INSAG4, 1991). Para ello, como mínimo, es necesario desarrollar los siguientes cuatro aspectos articulados:

* La cultura de seguridad de los valores humanos, la justicia y la excelencia;* La cultura de seguridad de la flexibilidad y la colaboración;* La cultura de seguridad de la comunicación y la presentación de informes;* La cultura de seguridad del aprendizaje crítico y la reflexióncontinua.

Estos aspectos se extienden entre los propuestos por Reason (1997) y coinciden en que una cultura de seguridad adecuada es alcanzable por las actividades humanas, aunque sea muy difícil de realizar sin esfuerzo, pues no es algo que exista de forma natural entre los miembros de una organización o en su estructura, sino que debe ser generada, desarrollada y consolidada a través de múltiples acciones estratégicas y sistemáticas.

Percepción del riesgo y su evaluación: clave en las estrategias de prevención

Una perspectiva de ingeniería en materia de seguridad está asentada históricamente sobre la base de identificación de las deficiencias en el diseño de los sistemas tecnológicos y de operación. A nivel de diseño conceptual, esbozos simplificados y/o críticos crean grandes incertidumbres sobre la seguridad real y el funcionamiento del sistema integral (Stoop et al., 2007). La certeza en la fase de diseño conceptual es absolutamente clave para la gestión de riesgos, debido a los peligros implícitos en los procesos, las tecnologías, los productos y/o servicios, las herramientas, los procedimientos -entre muchos otros aspectos- que incontables veces no pueden ser identificados cualitativamente y, mucho menos, cuantificados.

Además, cuando se generan cambios en las operaciones del sistema a largo plazo, se pueden producir desviaciones en las especificaciones de diseño y uso previsto. Tales desviaciones fuera de diseño pueden provocar la aparición del riesgo y/o fracaso en el sentido de la misión que intentaban llevar a cabo (Petroski, 1992). Para prevenir la recurrencia de un fallo inexplicable, un diseñador u operador tiene que actuar antes que intentar comprender lo sucedido. Luego, una vez que las medidas cautelares de precaución e intervención correctiva inmediata se hanadoptado, es necesario una investigación más extensa del error para entender el mecanismo por el cual se ha producido el fallo (Carper, 2001). Desde su concepción, una respuesta oportuna se basa en el principio de precaución, con el fin de proteger a los operadores de las amenazas graves o de daños irreversibles. La falta de certeza científica absoluta no deberá utilizarse como razón para postergar la adopción de medidas eficaces inmediatas para impedir la degradación adicional del sistema objeto de intervención correctiva. Posteriormente al accidente y a la mitigación inmediata de sus efectos, tal falta de certeza deberá ser resuelta lo antes posible mediante las investigaciones y estudios técnicos pertinentes (Stoop, 2009). En dicho sentido, la investigación de accidentes ha demostrado su valor como un instrumento analítico en la solución de las deficiencias de conocimientos y en la reducción de las incertidumbres sobre el funcionamiento de los sistemas y de los procesos. Dentro de la industria u organizaciones en general, la adopción de la filosofía de cero defectos se ha convertido en un enfoque fundamental de seguridad activa en proyectos singulares y de diseño seguro, a una escala sin precedentes.

Las certezas o incertidumbres que contienen los diseños de los sistemas, procesos y otros dispositivos de la vida laboral, o las percepciones que sobre ellas poseen los agentes organizacionales, se transforman en un asunto fundamental y estratégico en las lógicas de gestión de la seguridad que se intentan desarrollar. En tal sentido, la percepción del riesgo es una cuestión muy controvertida, ya que varía de individuo a individuo y puede conducir a inconsistencias en la etapa de análisis de riesgo (Cox y Tait, 1998). Según Fleming y Lardner (1999) y Geller (2001), la percepción de riesgo puede estar influida por la siguientes factores: a) lo que se conoce sobre el riesgo, incluidas las repercusiones posibles en el futuro; b) el nivel real de control de la situación; c) el conocimiento de la situación y la comprensión de las influencias externas; d) la profundidad del conocimiento de la tarea, si las consecuencias potenciales se refieren a las experiencias cotidianas o requieren de conocimientos especializados; e) la experiencia y la frecuencia de realización de la tarea anterior; y f) de la posibilidad de imaginar vívidamente los resultados o impactos. La complacencia puede ser muy peligrosa si el trabajo se realiza de forma rutinaria ya que conlleva a un riesgo de habituación: las actividades con consecuencias de nivel bajo –aunque tengan altos niveles de frecuencia- son propensas a ser subestimadas (Makin y Winder, 2008).

Según Lennart (2001), otros factores muy importantes en el riesgo percibido son: la actitud de sensibilidad al riesgo en general y las especificaciones que se poseen de los componentes del riesgo.

Hoy en día, la palabra riesgo se utiliza como un concepto que caracteriza tanto a las sociedades como así también a los principales procesos y fenómenos sociales. Así, el sociólogo Ulrich Beck presentó el concepto de sociedad del riesgo en 1986 y su tesis dio origen a nuevas contribuciones y al contraste de las opiniones de otros estudiosos, como Anthony Giddon y Nikla y el análisis de Luhmann en la década de 1990. En tal sentido, el riesgo sería una propiedad de las sociedades modernas con características claramente diferentes de los riesgos en la industria. Las sociedades modernas dominadas por la globalización, la tecnología y las comunicaciones tienen riesgos inherentes que han ido creciendo en extensión e importancia. En los últimos años, la terminología se ha complementado con conceptos holísticos importantes en la percepción y abordaje de los riesgos como, por ejemplo, el de risk management o gestión del riesgo (Stoop, 2009).

En el núcleo de la tradición de evaluación de riesgos está incluida la probabilidad y la dimensión de la incertidumbre. Si bien los analistas de riesgos pueden considerar a esta afirmación obvia, sin embargo existen diferentes tradiciones y formas de pensamiento (paradigmas) sobre esta cuestión, tal como el punto de vista sobre el riesgo adoptado por Willis (2007), quién indica que “el riesgo se define por las consecuencias esperadas de una amenaza inexistente”. El uso de esta perspectiva para la clasificación de la criticidad y la asignación de recursos significaría unenfoque completamente diferente en comparación con -por caso- Aven (2007a), quién pone de relieve la dimensión de la incertidumbre del riesgo. Para el riesgo de terrorismo -por ejemplo- donde las posibles consecuencias podrían ser extremas y las incertidumbres en los fenómenos y procesos subyacentes son grandes, es evidente que el valor esperado calculado puede ocultar aspectos importantes de la preocupación por la gestión del riesgo. El valor esperado calculado puede ser pequeño, digamos 0,01 víctimas mortales, pero pueden ocurrir eventos extremos bioterrorismo) con millones de muertes, y esto requiere una atención especial. Para Apostolakis (2005), una forma de representar este aspecto de riesgo esespecificar la probabilidad de un suceso que trae como consecuencia grandespérdidas, como por ejemplo, la probabilidad de que se produzca un hecho que conduce a un gran número de víctimas mortales. Sin embargo, en caso de grandesincertidumbres en los fenómenos y procesos subyacentes -como en el indicado deterrorismo- es difícil determinar las probabilidades, con una precisión suficiente, y en función del riesgo de criticidad, parece difícil de aplicar. Así, la evaluación deriesgos es una herramienta con extensas limitaciones presentes (Aven, 2003; Uff, 2000; Johnson, 2007).

La probabilidad no es una herramienta perfecta para expresar las incertidumbres. Las probabilidades asignadas están condicionadas por la información disponible de antecedentes específicos y podrían producir predicciones pobres. Por lo tanto la gestión del riesgo tiene que ver más allá de los números emergentes de riesgos calculados. Pueden ocurrir sorpresas en relación con las probabilidades asignadas (Aven, 2007a, 2007b). Taleb (2007) presenta una conclusión similar utilizando la “lógica del cisne negro”: la incapacidad para predecir los valores atípicos (cisne negro) implica la incapacidad para predecir el curso de la historia; un valor extremo se encuentra fuera del ámbito de las expectativas regulares, porque no hay nada en el pasado que de manera convincente puede apuntar a su ocurrencia; así, las herramientas estándar para la medición de incertidumbres no son capaces de predecir estos cisnes negros, al momento que se presenten.

Abandonando tales especulaciones y centrando el análisis en la gestión de la seguridad, no se trata de administrar y gestionar en base a la lógica exclusiva de la eliminación de errores, sino a una detección oportuna y adecuada recuperación de los errores (Leveson, 2004). Cuando la eliminación de los riesgos no es una opción viable, los métodos para hacer frente a la posibilidad de peligro, proporciona una alternativa razonable, y -en algunos casos- esto sólo puede implicar la creación de conciencia para afrontar los problemas que surjan (Pollock, 1999).

Los indicadores de riesgo en una organización deberían ser una herramienta para su evaluación y control durante la operación rutinaria de las instalaciones y como un complemento de otros indicadores habitualmente utilizados para describir comportamientos en otras dimensiones de la vida organizacional. El modelo de TQM hacer referencia a seis dimensiones claves sobre las que hay que construir sets de indicadores que contribuyan a un tablero de control sobre el desempeño integral de la organización. Tales dimensiones son: calidad intrínseca, costo, entrega, seguridad, ambiente y moral; lo que implica que tal modelo hace explicito el requerimiento y la necesidad de abordar la dimensión seguridad, como una de las pocas claves en la vida organizacional. Se debe abordar y desarrollar marcos teóricos y modelos -sobre la base de una revisión de los factores claves de organización y gestión- para la investigación y definición de un set de indicadores de desempeño en los aspectos de seguridad de cada organización. Los indicadores de riesgo, cuando se hallan validados, serán de ayuda importante en el control sistemático de los riesgos (Øien, 2001).

Información e incertidumbre en la gestión del riesgo

Cuando se efectúa una evaluación de riesgo, y a la hora de informar, debe tenerse en cuenta qué tipo de información va a suministrarse. También es muy importanteapreciar el grado de incertidumbre que existe en la información que se suministrará, ya que puede traer aparejado consecuencias no deseadas a la hora de prevenir accidentes. El dato, junto a su teoría interpretativa, así como la confiabilidad de las fuentes consultadas / relevadas para poseer los mismos y el contexto en el cual se observa e interpreta, son claves a la hora de la construcción de un conocimiento pertinente y de calidad sobre las situaciones que se abordan.

Un grupo de personas responsables de la gestión de riesgos, convocadas por el American Industrial Health Council y otras organizaciones, identificaron algunas necesidades básicas con respecto a la información que debe proporcionarse en relación con la evaluación de riesgos (AIHC, 1989). Así, revelan que tal presentación debe ser global y comprensible; la aplicabilidad y utilidad de la evaluación debe estar claramente indicada; la presentación debe ser creíble y plenamente justificable (por lo que no dará lugar a sorpresas después de efectuada) y el informe de evaluación de riesgos deberá contener un claro y – relativamente- breve resumen [1].

En los resultados de otro taller patrocinado por tal organización, se afirma que los análisis de riesgo deben ser pertinentes, oportunos y comprensibles, y deben proporcionar una variedad de medidas de riesgo, así como una clara declaración de incertidumbres (AIHC, 1992).

Entre las cuestiones clave que normalmente se consideran la hora de tomar decisiones relacionadas con el riesgo –y por tanto necesitan ser comunicadas en informes escritos o presentaciones orales- Bloom y Byrne (1993), basado en los aportes de un focus-group con administradores de la US Environmental Protección Agency (EPA), indican lo siguiente: los requisitos legales; los posibles efectos adversos de los peligros; las opciones disponibles para reducir el riesgo; el grado de preocupación acerca de la cuestión por parte de diversos grupos, y la fiabilidad de la información en la que la decisión se basa, entre otros.

Bloom et al. (1993), recomiendan que los informes o comunicaciones de aspectos sobre riesgos deben contemplar tanto los aspectos cuantitativos como cualitativos y deben incluir las discusiones de cualquier incertidumbre clave (por ejemplo, ciertas diferencias significativas en la información de base que se dispone). Igualmente, los gestores de riesgos deben brindar caracterizaciones de los riesgos tanto cualitativas como cuantitativas y deben presentar, no sólo las estimaciones de riesgo, sino también las fuentes y magnitudes de incertidumbre asociadas con estas estimaciones.

Una necesidad fundamental al identificar la información, como lo establecen Balch y Sutton (1995), es el deseo de los responsables jerárquicos de tener más control sobre los problemas, de tal modo de intentar evitar las crisis en lugar de gestionarlas. Así, recomiendan que la comunicación de riesgos debe ser proactiva, ayudando a los tomadores de decisiones a identificar las respuestas más probables y las diversas opciones y alternativas de decisión bajo consideración. Siguiendo dicha línea, Rowan (1991) sugiere que un efecto de la comunicación de riesgos puede ser aumentar la conciencia sobre un peligro o concerniente a un problema particular y así ayudar a evitarlo o prevenirlo, pues, los esfuerzos no deben limitarse a la evaluación formal de los resultados del análisis de riesgos y su comunicación, sino también incluir notificaciones de posibles problemas que pudieran ocurrir a futuro.

Balch y Sutton (1995) tienen en cuenta la necesidad de mostrar éxito por parte de los analizadores y gestores de riesgos, de modo que sugieren que “…incluso los pequeños esfuerzos pueden valer la pena si dan lugar a las primeras victorias…”. También señalan que la información útil debe estar disponible no sólo en el momento de una decisión inicial (por ejemplo, durante la planificación del programa), sino también cuando un programa está en marcha. Por lo tanto,recomiendan que los comunicadores de riesgos deben efectuar sus investigaciones durante la ejecución del programa, no sólo en su inicio y su final. La investigación debe incluir el diagnóstico, la retroalimentación y mecanismos de alerta temprana y rápida de ajustes en el programa, seguido de información sobre la forma de realizar los ajustes; también recomiendan consultar con los directivos antes de que un análisis de riesgo se realice realmente, para determinar cómo se usarán los resultados. El AIHC recomienda que los usuarios potenciales de análisis de riesgos - y sus preocupaciones- deben ser identificados en forma prematura, de modo que cada análisis de riesgo pueda ser diseñado para responder a cada preocupación o serie de preocupaciones específicas. Del mismo modo, Balch y Sutton hacen fuerte hincapié en que los analistas y gestores de riesgos -en sus comunicaciones con los actores organizacionales o públicos- deben prometer sólo lo que pueden cumplir para evitar cualquier pérdida de credibilidad acumulativa.

Si bien la información sobre las incertidumbres es un insumo esencial para toma de decisiones reguladoras, es -a menudo- especialmente difícil de comunicar. Por otra parte, la teoría de la toma de decisiones en condiciones de incertidumbre es un tema muy técnico y, con frecuencia, no les es transparente a los tomadores de decisiones que no están capacitados en esta metodología. Es conocido que la incertidumbre puede afectar de varias formas a la toma de decisiones, pero resta por conocerse aspectos sobre cómo abordar eficazmente estas cuestiones en la comunicación de riesgos. Morgan y Henrion (1990) describen los beneficios de “…el valor de saber lo poco que uno sabe…”, pues observaron que en la gran la mayoría de los casos, teniendo en cuenta la incertidumbre (aunque sea con información limitada) se llega a una mejor decisión que al ignorar la incertidumbre y confiar en metodologías simplificadas -o dejarse vencer por tendencias reduccionistas- para el análisis cualitativo o el cálculo.

Para ayudar a aclarar el concepto del valor de la información, Brown y Ulvila (1987) distinguen entre incertidumbre del resultado (lo que realmente puede suceder y con qué probabilidad) y la incertidumbre de la evaluación (la cantidad de resultados de los análisis que pueden cambiar con la información adicional). Los autores señalan que la incertidumbre del resultado es la preocupación de los tomadores de decisiones que deben llegar a una decisión final inmediatamente, mientras que, tanto la incertidumbre del resultado como la incertidumbre de la evaluación, son de interés para los tomadores de decisiones que tienen la opción de recaudar más información antes de decidir. Indican que, al hablar de la evaluación de la incertidumbre, hay que distinguir también entre información ilimitada (o perfecta), frente a las cantidades de nueva información que podrían resultar de un esfuerzo de investigación realista de la información o el análisis que en realidad podría estar disponible. Señalan que la nueva información no sólo puede reducir la incertidumbre de resultados, sino que también puede ocurrir un cambio de la estimación central de ese resultado.

La incertidumbre o la subestimación del compromiso con los valores utilizados en las evaluaciones de riesgo cuantitativo, pueden conducir a un falso sentido de confianza en los resultados del proceso de evaluación de riesgos. Por lo tanto, este proceso es más fiable cuando los problemas son de carácter previsible, o cuando las pruebas son sustanciales para apoyar las afirmaciones (Standards Australia, 2004). Otro inconveniente con la metodología de gestión de riesgos es que su aplicación puede revelar largas listas de problemas que requieren gastos de capital y existe la posibilidad de que los fondos reservados para hacer frente a las cuestiones de seguridad puedan ser transferidos a otros proyectos aparentemente más urgentes.

Costos de accidentes e inversiones en seguridad laboral

El costo de las lesiones y los accidentes en una organización es uno de los factores que deben evaluarse para establecer cuántos recursos podrían destinarse para laprevención de riesgos y en el control de la salud y seguridad laboral. A pesar de la utilidad de tal información, no forma parte de la práctica contable habitual que estos datos estén disponibles. De dos tipos de gastos efectuados por una empresa, destinados a las lesiones y los accidentes -los costos directos e indirectos- los primeros son mucho más fáciles de calcular. Sin embargo, los costos no indirectos no asegurados suelen ser más críticos y deben ser estimados cuidadosamente.

Sona et al. (2000), investigaron un modelo general para estimar los costos generados por los accidentes y para establecer un control de seguridad eficiente, utilizando una empresa de construcción como organización piloto del estudio. Mediante el análisis de los datos reales de la empresa durante tres años, se comprobó que el control eficiente de los gastos de seguridad se situaba en el orden del 1,2% al 1,3% de los costos totales del contrato.

Los recursos de gestión de la seguridad se invierten de manera muy diferente en los distintos campos de actividades, y en la mayoría de las organizaciones y países no hay orientaciones disponibles sobre cómo determinar el costo estándar de seguridad. Las erogaciones correspondientes a la gestión de la seguridad, para cada área y en las diferentes empresas, según Sona et al., podría depender del tipo de proceso de trabajo, de la probabilidad de ocurrencia de accidentes y de otros factores particulares de cada industria o la empresa en análisis.

Con el fin de determinar el nivel más adecuado de inversión en gestión de seguridad debe tenerse en cuenta un nuevo método de orientación práctica de la estimación de los costos directos, gastos de seguros generales y compensaciones, así como diversos costos indirectos, tal como paros laborales, tiempo necesario para llegar a instrumentar compromisos legales, diversas actividades ulteriores que involucra un accidente (i.e. limpieza de escombros, etc.), y los costos asociados con la desmoralización y desmotivación de la fuerza de trabajo. Ésta última, es un área de particular dificultad es la estimación de los costos (de tipo indirecto), pues son difíciles de determinar a raíz que -por lo general- no hay registros de datos sobre ello en las organizaciones (Sona, et al., 2000).

Ciertas corrientes de pensamiento proponen que el nivel de inversión en gestión de seguridad, para cada tipo de de trabajo, debe ser objeto de cálculo, revisión y fundamentación/aclaración para determinar su rentabilidad. En consecuencia, es conveniente seguir un modelo detallado para establecer el nivel óptimo de inversiones en gestión de seguridad: si se tienen en cuenta los diversos costos que generan los accidentes, se puede evaluar cuanto se puede invertir en prevención y en gestión de riesgos emergentes; y además, relacionando ambas cifras, calcular un valor de rentabilidad aparente de las inversiones realizadas. Este modelo es, posiblemente, mejor aplicarlo en relación con los objetivos financieros generales de la empresa. De todos modos sus limitaciones son claras: desde una perspectiva humana, por ejemplo, ¿Cuál es el costo del sufrimiento de una serie de trabajadores y sus familias ante accidentes con lesiones importantes, amputaciones y/o muertes en aquellos?.

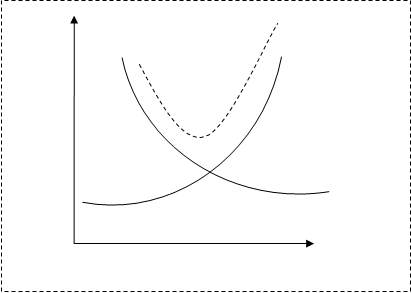

La Fig. 1 muestra una relación conocida entre el grado de seguridad y los costos totales (Melchers, 1999). Cuanto mayor sea el diseño, la ingeniería, la implementación y los niveles de seguridad, menores serán los costos totales previstos, debido a la menor probabilidad de accidentes.

Costo total

Costo

Costos de accidentes

Costos de control de contramedida

|

|

Grado de seguridad Fig., 1 Costo de seguridad (Melchers, 1999). |

Sin embargo, para alcanzar estos niveles superiores de seguridad serán necesarios costos extras, costos que normalmente han de ser sufragados por el contratista y determinar así el mínimo general de los costes totales previstos (Stranks, 1986).

De la figura anterior se pueden establecer algunos de los límites en las curvas. Es claro que, en un perfecto estado de seguridad, no habrá accidentes y por lo tanto no habrá costos asociados con ellos. Por el contrario, lograr un perfecto estado de seguridad implica que los costos son infinitos. Un estado viable de la seguridad se encuentra en algún punto entre estos dos extremos (Grimaldi, 1984).

Al añadir a esta curva los accidentes esperados o los costos de los daños y los costos de control de contramedidas, se puede obtener la curva de costos totales previstos. Evidentemente, según Sona et al. (2000), esta curva tiene un punto mínimo para el costo total donde la derivada del costo total esperado es cero.

El costo total previsto se puede dividir en las dos categorías ya indicadas: (i) directos, e (ii) indirectos. Se ha visto que los costos directos incluyen daños a la propiedad, los costos de las lesiones y los costos involucrados en el cuidado de los afectados, entre otros; y que los costos indirectos son más difíciles de determinar, pues ellos se refieren principalmente a la pérdida de la productividad individual, la pérdida de la productividad del sistema, y los costos impredecibles de los seguros y litigios (entre muchos otros, dependiendo desde que perspectiva y valores se analiza). También los costos directos incluyen los cambios de diseño originados en ciertas intervenciones correctivas y preventivas originadas en factores de seguridad laboral y ambiental, la provisión del personal de gestión de SySO, instalación y gestión de los diversos sistemas técnicos de seguridad, la educación y los programas de capacitación, entre otros. Aquí se puede agregar que, a menudo y en la práctica, los costos indirectos suelen ser superiores a los costos directos. En tal sentido, se ha sugerido que las pérdidas indirectas pueden ser de hasta cuatro veces los costes directos (Roland y Moriarty, 1990) pero, en la práctica, esta relación es un tanto difícil de calcular.

En definitiva, un criterio básico es que el mínimo de los costos totales previstos de los diversos daños probables (estimados por los antecedentes propios y/o la siniestralidad promedio en el sector), podría considerarse como el mejor criterio – por default- para el establecimiento de unos niveles de inversión en seguridad, si bien no óptimos, tal vez posibles.

Estrategias de identificación y control de los sistemas críticos

La identificación de los peligros y sus medidas de mitigación y control correspondientes, proporcionan la base para un programa de seguridad en las organizaciones y, esencialmente, determinan el alcance, contenido y complejidad del sistema de gestión de la seguridad y la salud en el trabajo (Mearns y Flin, 1995). Si esta etapa se realiza de modo inadecuado o de manera insuficiente, desde el punto de vista de la extensión, profundidad y rigurosidad metodológica de la investigación efectuada para identificar los peligros y valorar los riesgos asociados, la capacidad organizacional para proteger la salud y la seguridad ocupacional será limitada y estará afectada potencialmente su integridad. Uno de los problemas detectados asiduamente en los procesos de gestión de riesgos -por obra de la actuación del paradigma simplificatorio en sus gestores y responsables- es que habitualmente se trabaja sólo con una versión ultra abreviada de la complejidad real del sistema y de los procesos organizacionales, incluso sin tener en cuenta el contexto en donde se desarrollan los riesgos laborales.

Las principales estrategias de control que han surgido para tratar con los riesgos en el lugar de trabajo son: conocimientos extensos, capacidades y habilidades importantes en los gestores, la existencia de un ambiente adecuado, personas de confianza y seguridad intrínseca en los sistemas (Makin y Winder, 2008).

Los riesgos psico-sociales son frecuentemente no abordados, como suelen también minimizarse la incidencia de los problemas relacionados con la forma en que el trabajo se estructura y organiza (Johnstone, 1999). Un análisis completo puede desarrollarse partiendo de considerar los riesgos potenciales asociados a cada uno de los elementos claves que se combinan en el desempeño de una organización. Estos comprenden: las personas a quienes se les encomiendan diversas tareas y se le asignan otras tantas responsabilidades; el lugar de trabajo -o ambiente físico- y las tecnologías que utilizan los agentes organizacionales para la producción de bienes y/o servicios; y los cuadros medios con responsabilidades gerenciales, designados para organizar y dirigir la transformación de los recursos en la organización.

De hecho, pueden surgir peligros en el lugar de trabajo y al interior de todo sistema, por cambios en cualquiera de tales tres elementos, ya sea en sí mismos, en las interfaces entre ellos o en los límites con el ambiente externo. El reconocimiento de estas tres áreas críticas –además de los factores individuales- surge como un tema recurrente en la literatura científica sobre el estudio y administración de los riesgos laborales; sin embargo, ha habido una tendencia general a concentrarse en áreas particulares (preferencias en el abordaje de algunos subsistemas sin sus interrelaciones significativas con otros subsistemas organizacionales y el medio externo) en lugar de considerar el riesgo total (Markin y Winder, 2008).

Si se centra el análisis en las personas, la baja moral en un grupo de agentes de cierto sector de la organización -incrementada por cierta resistencia al cambio- sería un ejemplo de una condición riesgosa resultante de ciertas estrategias de cambio e intervenciones preventivo/correctivas (u otras diversas, de distintos orígenes). Esta baja moral y el estrés en el trabajo asociado a tal condición, puede ser indicada por inusuales altas tasas de rotación e incremento en los niveles de ausentismo (Cowie et al., 2002; Dollard y Knott, 2004). Por su parte, Deming (1986) señala que ciertos peligros generados dentro de la gestión pueden derivarse de la falta de liderazgo de los cuadros gerenciales o la ausencia de compromiso de la fuerza laboral, incluso de cierta tensión originada por la intensa competencia dentro de un sector de negocios. Otras fuentes de peligros, que podrían poner a los trabajadores en un riesgo mayor de enfermedades y lesiones, pueden originarsepor la ausencia de familiarización de los gestores con sus obligaciones legales o de la falta de compromiso con mantenerse informado de los cambios científico- tecnológicos relativos a aspectos de SySO. La decisión de recurrir a la contratación de personal eventual, en contraposición con la utilización de empleados permanentes, pueden generar riesgos debido a la inestabilidad laboral y la falta de conocimiento suficiente de los nuevos agentes de sus roles y los entornos de trabajo (Quinlan y Mayhew, 2001). Los peligros también pueden desarrollarse en respuesta a la cultura de la empresa (por ejemplo, si la presentación de informes de incidentes se ha desalentado por alguna razón) y en la medida en que la seguridad no es valorada adecuadamente por la organización (Geller, 1994; Richardson, 1997; Hopkins, 2000).

Se han desarrollado una serie de iniciativas para determinar la seguridad de los sistemas críticos y sus actividades asociadas, en diferentes niveles y en distintos contextos, que –por ejemplo- van desde las infraestructuras (a nivel de la sociedad) a los equipos, en el nivel de una planta de producción. Los diferentes enfoques se aplican para definir los sistemas críticos y las actividades conexas con ellos. Algunas de estas iniciativas se basan en las vulnerabilidades observadas en los sistemas y otras en la incorporación de la dimensión de la probabilidad de ocurrencia de ciertos eventos riesgosos; también existen enfoques que tienen en cuenta los valores que se sustentan en la toma de decisiones y los modos del involucramiento de los múltiples interesados (internos y externos). En un buen número de ellas, la principal preocupación emerge de las actividades con posibles consecuencias graves, asociadas a grandes incertidumbres (Aven, 2008).

Para apoyar la toma de decisiones relativas a las cuestiones de seguridad, se considera una tarea sumamente importante a la identificación de los sistemas y actividades críticas. La motivación para la identificación de los sistemas críticos es la necesidad de dar prioridad a las actividades y recursos diversos aplicados a los procesos de reducción del riesgo presente y en materia de seguridad laboral, en general. Las tareas de gestión del riesgo laboral van a centrarse en los sistemas que aparecen como priorizados en tal estudio de criticidad.

Básicamente, se pueden distinguir dos categorías de criticidad; así, un sistema o actividad es crítica si:

- 1. La vulnerabilidad es alta y/o

- 2. El riesgo es alto.

El primer tipo de interpretación es la de uso más común. Según algunos autores (Falla, 1997; Cricitti et al, 2004; Gortman et al, 2004; Latora et al, 2007; Johansson, 2007), un sistema se considera crítico si su fallo o mal funcionamiento puede resultar en graves consecuencias (por ejemplo, relacionados con la pérdida de vidas, daños al medio ambiente o pérdidas económicas).

Recientemente, y desde este enfoque en la vulnerabilidad, ha habido una especial atención en las infraestructuras críticas. Según Gheorghe et al (2006) y Johansson (2007), una infraestructura crítica puede ser conceptualizada como organizaciones e instalaciones de importancia clave para el interés público o privado, cuyo fallo y/o deficiencia (o deterioro) podría dar lugar a la escasez perjudicial de la fuente (suministro), alteración o disturbio sustancial para el orden público o de impacto dramático similar. Una definición más general de un sistema crítico en un contexto social, según Johansson (2007), es la siguiente: un sistema crítico es un sistema que, en su defecto, repercutiría negativamente en la sociedad.

La evaluación de las vulnerabilidades podría reflejar valores explícitos en la toma de decisiones para los interesados, como en el enfoque sugerido por Apostolakis y Limón (2005): a partir de una identificación de los conjuntos de corte mínimo de lared de infraestructura (combinaciones de fallos de los componentes del sistema), denominado MCS (Minimal Cuts Set), una medida crítica es definida con base en una desutilidad de los MCS. Si la medida critica es mayor para el corte mínimo establecido “i” que para el corte mínimo establecido “j”, entonces la toma de decisiones que evalúa la vulnerabilidad es de mayor desutilidad; es decir, tiene más 'valor' la vulnerabilidad de “j”. Lo ideal sería poner en práctica un procedimiento de riesgo, basado en el valor esperado para la toma de decisiones de las consecuencias de las vulnerabilidades. Sin embargo, desde ese enfoque sería necesario el uso de las probabilidades que no se han obtenido con rigor, y ellos mismos se ven obligados a recurrir a un enfoque más pragmático, con una evaluación conservadora de la desutilidades del MCS.

La segunda categoría de medidas de criticidad (el riesgo es alto), incluye la probabilidad de que el evento ocurra. En tal sentido, Jenelius et al. (2006) define la criticidad como el producto de la probabilidad y la importancia (de la criticidad condicional), en donde la importancia refleja el aumento de los gastos en caso que el evento ocurra. Esta categoría también incorpora los riesgos tradicionales y las medidas de importancia de fiabilidad (Modarrea, 1993; Aven, 1999). Dos de las medidas más comunes son las de Birnbaum y el potencial de mejora (también conocido como el valor de la reducción del riesgo), según lo explicitan Aven (2003) y Van Der Borst y Schoonakker (2001). La medida anterior se define por la sensibilidad (derivada parcial) de la confiabilidad (riesgo) con respecto al parámetro (por ejemplo, la fiabilidad de una barrera de seguridad). Esta última medida expresa la contribución de riesgo de un sistema específico, determinado por el cálculo de la diferencia en los índices de riesgo, asumiendo que el sistema no tiene fallas o mal funcionamiento.

La incertidumbre y la dimensión de probabilidad deben tenerse en cuenta; también se debe ser cuidadoso al utilizar sólo la vulnerabilidad como una medida de la criticidad. La vulnerabilidad depende de cómo se defina el inicio de los acontecimientos (las perturbaciones que originan el evento) y redefiniendo ello, la vulnerabilidad puede cambiar de manera significativa (Aven, 2008).

Cuando se habla de identificar los sistemas críticos, se debe tener en cuenta que las probabilidades no son números objetivos y la información de base para las asignaciones que realicen los analistas (suposiciones y conocimientos) podrían ser pobres, de allí que podrían resultar inexactas las predicciones que se efectúen en contraposición a los resultados reales. Por lo tanto, centrándose en las consecuencias esperadas y dado un modo de fallo, se presenta un fuerte elemento de arbitrariedad en la clasificación de régimen. Esta arbitrariedad se debe a la variación en los posibles resultados integrados en el valor esperado, así como en la dificultad de asignar probabilidades y de producir predicciones exactas (Aven, 2008). La clasificación de la criticidad sobre la base de esta forma de pensamiento tiene fuertes limitaciones. Según Aven, se debe proceder con cuidado al utilizar la vulnerabilidad como la base para la clasificación de la criticidad.

La definición de riesgo y criticidad, en función de la pérdida esperada, significa que no hay distinción entre las situaciones con posibles consecuencias grandes y probabilidades pequeñas asociadas y eventos frecuentes que ocurren con consecuencias bastante pequeñas, siempre y cuando el producto de los posibles resultados y las probabilidades sean iguales. Para la gestión del riesgo de estos dos tipos de situaciones, normalmente se requieren enfoques diferentes (Aimes, 2004) y, por lo tanto, se tiene que ver más allá de los valores esperados cuando se evalúa el riesgo y la identificación de los sistemas críticos. De la discusión anterior, se puede concluir que no existe algún ideal para usar como una medida de la criticidad (Aven, 2008).

En la tarea de identificar las infraestructuras críticas, una preocupación importante es la interconexión cada vez mayor de infraestructuras. Las infraestructuras críticasson identificadas para proporcionar una base para la determinación de la adecuada protección y mitigación de medidas, y por lo tanto, reducir las vulnerabilidades y los riesgos. Si una infraestructura está clasificada como crítica, se pueden utilizar más recursos para este propósito que si la infraestructura no se define como crítica (Aven, 2008). Sin embargo, este enfoque está sujeto a distintos tipos de problemas: por ejemplo, ¿Qué modos de fallo y escenarios deben constituir la base para la el análisis?. Si se definen pocos modos de fracasos y escenarios, las consecuencias deben basarse en los valores esperados, dado el fracaso, que podrían producir las pobres predicciones de los resultados reales. Ciertas consecuencias graves, pueden estar escondidas en los valores esperados. Y si son definidos muchos modos de fallo y muchos escenarios, pueden ser revelados demasiados resultados, pero su probabilidad puede ser muy pequeña. Esto lleva de nuevo a un riesgo, teniendo en cuenta también las probabilidades de los eventos, en este caso la probabilidad de un fallo de la infraestructura, ya sea causada por un accidente o por un acto intencional. Entonces, podemos definir los índices de riesgo basados en la pérdida esperada y desutilidad. La pérdida esperada puede referirse a las diferentes preocupaciones por separado o puede ser una medida integrada basada en una transformación de todas las preocupaciones a una escala común, como es a menudo efectuado en una matriz de riesgos (Johnson, 2007a; 2007b).

Se podría argumentar que la incertidumbre y el riesgo relacionados con los acontecimientos iniciales no se deben tomar en cuenta como cualquier vulnerabilidad. Simplemente no podemos diseñar a favor de medidas operativas que pueden soportar todos los posibles peligros y amenazas. En un mundo práctico, nos enfrentamos con las limitaciones de recursos. Por lo tanto, necesitamos una manera de identificar lo que es importante y lo que no es tan importante, y esto no puede hacerse de una manera racional, sin también tener en cuenta la incertidumbre y el riesgo relacionados con los acontecimientos iniciales, es decir, sin considerar el riesgo. Obviamente, no vamos a juzgar a todos los acontecimientos, los peligros y amenazas, aunque sean probables.

Se busca una forma de clasificar las infraestructuras de acuerdo a la criticidad y reconocer que el riesgo tiene que ser tenido en cuenta. La cuestión clave es cómo debe hacerse (Aven, 2008).

Formalmente, se considera al riesgo como la incertidumbre acerca de la gravedad de las consecuencias de la actividad en cuestión, respecto a algo que los seres humanos consideran de valor (Aven y Renn, 2008); y la vulnerabilidad asociada con el inicio de un evento, como una incertidumbre acerca de la gravedad de las consecuencias, dada la ocurrencia del evento. Se utilizan probabilidades como una medida de la expresión de la incertidumbre. En tanto que la gravedad se refiere a la intensidad, tamaño, extensión, alcance y otras posibles medidas de magnitud (por caso, pérdidas y ganancias se pueden expresar mediante el dinero gastado o por el número de víctimas, y ambas son formas de definir la gravedad de las consecuencias). Es importante señalar que las incertidumbres se refieren a los acontecimientos, y la gravedad de las consecuencias son sólo una forma de caracterizar a las consecuencias. Este es un punto de vista del riesgo elegido, aunque existen otras perspectivas. La motivación para la adopción de esta perspectiva por encima de otras, según Aven (2007a) y Aven y Renn (2008) puede resumirse en los siguientes puntos:

- 1. El riesgo es superior a los valores esperados. Deben tenerse en cuenta incertidumbres.

- 2. La probabilidad no es una herramienta perfecta para expresar las incertidumbres, ya que pueden producir predicciones pobres.

Las probabilidades están basadas en una información de fondo que puede ocultar una serie de premisas y suposiciones, y las hipótesis y suposiciones pueden estar equivocadas porque el mundo real puede ser diferente, los fenómenos extremos y las situaciones pueden ocurrir -por ejemplo- con más frecuencia de lo previsto. De acuerdo a esta perspectiva, un grado bajo de incertidumbre no significa necesariamente un riesgo bajo, o un alto grado de incertidumbre, no significa necesariamente un riesgo elevado. El componente de incertidumbre se añade para reflejar que los resultados reales pueden desviarse considerablemente del número esperado y que las desviaciones son el resultado de las variaciones existentes en las poblaciones estudiadas.

En contextos de gestión y evaluación de riesgos, a menudo se ve que los modelos establecidos son basados en datos históricos. Estos datos pueden no incluir observaciones extremas, pero esto no se opone a que tal observación se produzca en el futuro. El análisis estadístico, se basa en la idea de situaciones similares y si ''similares'' se limita a los datos históricos, la población considerada podía ser demasiado pequeña o estrecha. La estadística necesita un modelo de distribución para poder realizar un análisis estadístico, y entonces basa su análisis en los datos disponibles. Es decir que tenemos que ver los valores esperados más allá de las probabilidades históricas y de base. En la compleja y mal estructurada situación de riesgo, quienes toman decisiones no se enfrentan sólo con la cuestión de riesgo, sino con la incertidumbre fundamental, caracterizada por la información incompleta en los conocimientos que se poseen.

CONCLUSIONES

La paradoja de que la cultura puede actuar simultáneamente como condición previa para las operaciones seguras o ser una incubadora de peligros, ha llevado a profundizar en los intentos teóricos y empíricos para estudiar la cultura organizacional y sus vinculaciones con la cultura de seguridad, y de ésta en relación con las percepciones sobre el riesgo presente y el desempeño de la organización referidos a la gestión de SySO. Aunque el resultado de tales indagaciones sean un tanto desarticuladas y fragmentadas, al menos han aportado a la superación del concepto de clima de seguridad, más coyuntural y superficial, por una mirada más holística y valiosa de los aspectos -macro y microscópicos- que operan en la vida organizacional para el desarrollo de criterios de gestión participativos hacia la construcción de organizaciones más seguras, saludables y responsables.

Queda claro que, en principio, y a los efectos de avanzar en tal sentido, una serie de acciones y métodos deben ejecutarse con el fin de identificar los errores activos o latentes –atribuidos a las personas- y los errores de organización que pudieran estar operando o gestándose. Contar con el conocimiento suficiente y las metodologías pertinentes para investigar exhaustivamente los factores inseguros, las condiciones inseguras y los actos inseguros, que pudieran estar activos o presentarse en la organización, se constituye en un aspecto clave para una planificación de intervenciones preventivo-correctivas posteriores y sus estudios de costo-beneficio, incluyendo las variables directas e indirectos en su valoración. Sumado a ello, abordar los diseños, las configuraciones de las infraestructuras –y sus complejas interrelaciones- así como los aspectos relacionados con la comunicación y la gestión del conocimiento sobre los asuntos de SySO –todos ellos subsistemas críticos del trabajo- contribuye a identificar las vulnerabilidades y los riesgos que pudieran presentarse dentro de las rutinas de trabajo.

Tener en cuenta la extensión, calidad y pertinencia de la información que se maneja sobre el riesgo, es primordial a la hora de tener que gestionarlo. Asimismo, las incertidumbres estadísticas y aquellas incertidumbres propias de la información que se maneja respecto a los riesgos, son aspectos que deben ser evaluados yconsiderados teniendo en cuenta que se debe llegar a posturas de equilibrio entre prevención e imprevisión, y que podría transformarse en negligencia -o hasta en improvisación- en caso de no manejar las variables suficientes y adecuadas a la complejidad del objeto en estudio. La cuestión de la participación y el aprendizaje continuo organizacional son claves en tal sentido, tanto como hacer hincapié en la importancia de la cultura de la seguridad como un concepto único capaz de mejorar la seguridad en sistemas complejos, basándose en tres dimensiones diferentes: la prevención, la protección y la mitigación.

Las estrategias y políticas activas de SySO pueden guiar a la acumulación de experiencias en la operación segura, saludable y responsable de los sistemas -que colaborarían con establecer una cultura de la seguridad activa- mejorando el conocimiento y la transparencia en los aspectos comunicacionales -relacionados ambos con ciertas percepciones del riesgo presente y futuro- y, complementariamente, aportar al desarrollo de confianza e involucramiento en los agentes organizacionales y actores externos relacionados.

REFERENCIAS BIBLIOGRÁFICAS

AIHC - American Industrial Health Council. (1989). US Environmental Protection Agency, Department of Health and Human Services, and Society for Risk Analysis. Presentation of risk assessments of carcinogens: report of an ad hoc study group on risk assessment presentation. Washington, DC: American Industrial Health Council, pp. 5 y 6. 1989.

AIHC - American Industrial Health Council. (1992). Center for Risk Management (Resources for the Future), and US Environmental Protection Agency.

Improving risk characterization; summary of a workshop held in Washington,

DC on 26 and 27 September 1991. Washington, DC: American Industrial Health Council, pp. 2. 1992.

Apostolakis, G.E.; Lemon, D.M. (2005). A screening methodology for theidentification and ranking of infrastructure vulnerabilities due to terrorism.

Risk Analysis 2005; 24(2):361–76.

Apostolakis, G; WU, J.S. (1995). A structured approach to the assessment of the quality culture in nuclear installations, Presented at the American Nuclear Society International Topical Meeting on Safety Culture in Nuclear Installations, Vienna, April 24±28, 1995. Australia.

Aven T. (2003). Foundations of risk analysis: A knowledge and decision-oriented perspective. New York: Wiley; 2003.